🤑⚡La fiebre del vatio y la fragmentación del stack de IA 🤖

Bitácora Semanal, Lunes, 09 de Junio de 2025 | El Futurista

Bienvenido a esta nueva edición de la Bitácora Semanal, esta semana, la conversación gira en torno a dos ejes principales: la insaciable sed energética de la Inteligencia Artificial y las maniobras geopolíticas que buscan fragmentar y dominar su stack tecnológico.

Hola 👋, soy Raúl Pacheco Rodríguez y todas las semanas te escribo una nueva edición de Bitácora Semanal 📰 la sección de El Futurista donde te comparto un análisis conciso y estratégico de las noticias y desarrollos más importantes en el mundo de la IA, para que empieces la semana informado y con perspectiva.

Las realidad energética de la IA

La Inteligencia Artificial, esa fuerza que promete remodelar nuestro mundo, está colisionando de forma cada vez más evidente con una de las limitaciones más fundamentales del mundo físico: la energía.

El crecimiento exponencial de las capacidades de la IA y su despliegue masivo están generando una demanda eléctrica que redefine el coste real de esta tecnología y forja alianzas estratégicas inesperadas.

Meta Platforms, por ejemplo, ha firmado un acuerdo de 20 años para asegurar energía nuclear de la planta de Constellation Energy en Illinois, buscando satisfacer las crecientes necesidades de sus operaciones de IA.

Este movimiento, que también expandirá la producción de la planta en 30 MW a partir de junio de 2027, no es aislado. Microsoft también ha explorado acuerdos nucleares, incluyendo planes para reiniciar un reactor en la planta de Three Mile Island, y tanto Amazon como Google están invirtiendo en reactores nucleares avanzados y pequeños reactores modulares (SMRs).

Estas alianzas entre gigantes tecnológicos y el sector energético subrayan una nueva realidad:

la geografía energética se está convirtiendo en un factor determinante para el futuro liderazgo en IA

La magnitud del desafío es considerable.

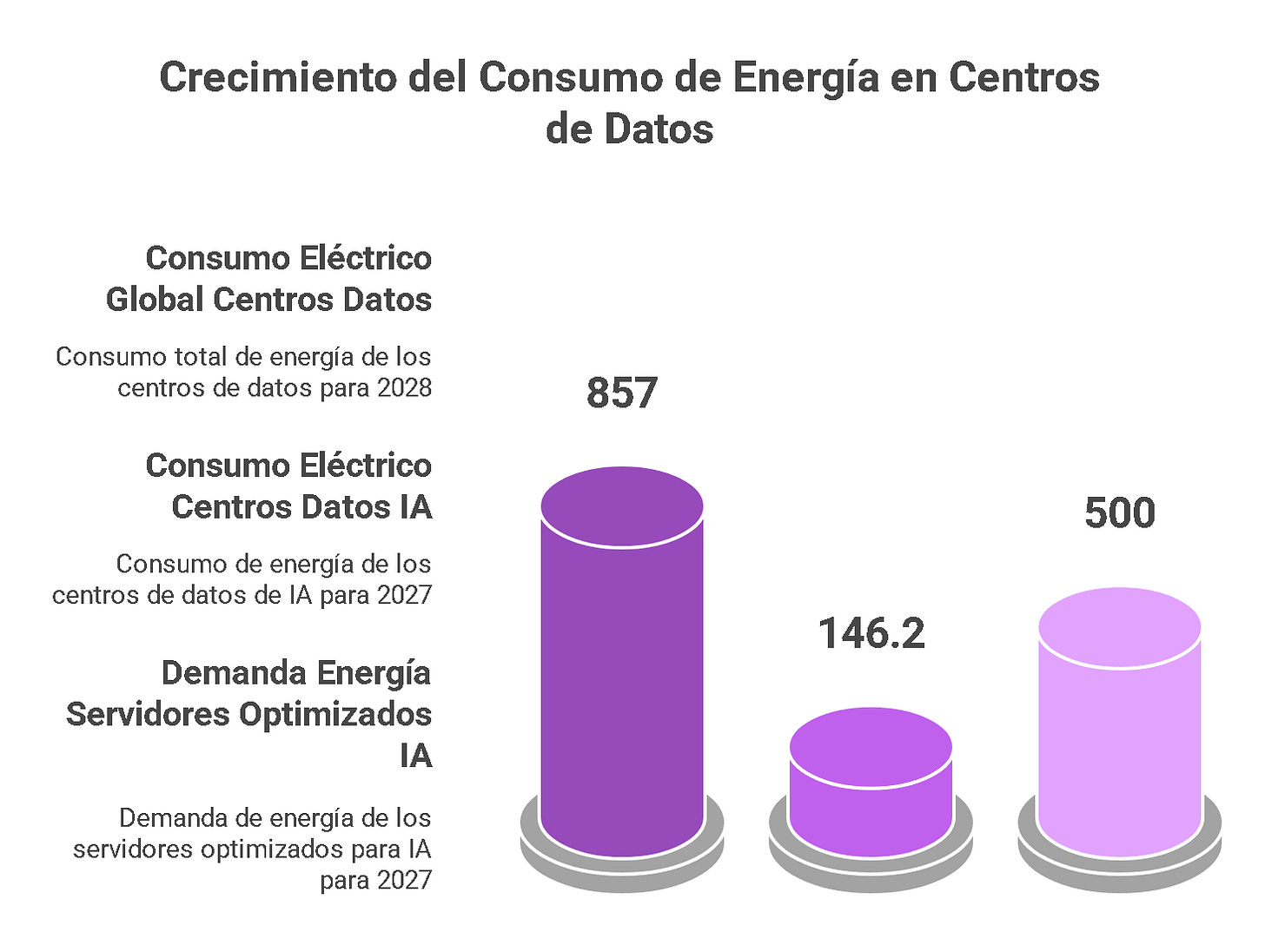

Un informe de International Data Corporation (IDC) proyecta que el consumo energético de los centros de datos dedicados a IA alcanzará los 146.2 TWh para 2027, con una tasa de crecimiento anual compuesta (CAGR) del 44.7% entre 2023 y 2027. Gartner estima que la energía requerida para los servidores optimizados para IA podría llegar a 500 TWh anuales en 2027.

Para ponerlo en perspectiva, el Departamento de Energía de EEUU estima que los centros de datos podrían consumir hasta el 12% de la electricidad del país para 2028.

Esta "Gran Vinculación Física" tiene profundas implicaciones. Primero, redefine el coste total de propiedad (TCO) de la IA, donde la energía se convierte en un componente masivo del CAPEX y OPEX, favoreciendo a actores con capital para inversiones a largo plazo. Segundo, la narrativa "verde" de las Big Tech se tensiona; aunque la nuclear se presenta como "limpia" , la urgencia también impulsa la construcción de plantas de gas dedicadas junto a centros de datos, especialmente en regiones como Texas , donde empresas como CloudBurst y Energy Transfer colaboran en estos proyectos. Esta dualidad podría ser un lastre para los objetivos climáticos si la dependencia de fósiles se consolida, o un catalizador para la energía nuclear avanzada si esta logra escalar.

📝 Futurinota: Si la energía es el nuevo "cuello de botella", ¿veremos una era de "nacionalismo energético digital" donde el control de los vatios dicte el liderazgo en IA, reconfigurando alianzas geopolíticas? ¿Se están convirtiendo las Big Tech en las nuevas "empresas de servicios públicos" del siglo XXI?

La estrategia "Android" de China para los agentes de IA: Guerra de estándares, no de funcionalidades

China está ejecutando una jugada maestra en el tablero de la IA global, una que recuerda a la estrategia de Google con Android.

Empresas como Zhipu AI, con su agente gratuito AutoGLM Rumination , y DeepSeek, al liberar modelos potentes como R1 bajo licencias permisivas tipo MIT , no están simplemente compitiendo en funcionalidades; están librando una guerra de estándares.

Esta ofensiva no busca ganar ofreciendo el "mejor" agente hoy, sino estableciendo una plataforma dominante mañana

Al regalar o abrir el código de las capas fundamentales –los modelos base y los agentes–, China busca una adopción masiva.

El objetivo es controlar las arterias del stack de IA (plataforma, APIs, formatos de datos), para que la innovación y el valor agregado (aplicaciones especializadas, servicios) se construyan sobre un estándar con ADN chino.

Esta estrategia de "soft power" tecnológico es especialmente atractiva para el Sur Global, que puede ver en estas herramientas gratuitas o abiertas una alternativa a las costosas y, a veces, restringidas tecnologías occidentales.

Podríamos ver una fragmentación del stack global de IA, con esferas de influencia tecnológica.

Las empresas occidentales que monetizan modelos básicos enfrentarán una presión competitiva feroz. Curiosamente, las restricciones de hardware impuestas por EEUU podrían estar catalizando esta estrategia china, incentivando la optimización del software y la conquista de cuota de mercado mediante la apertura.

📝 Futurinota: Monitorear estos ecosistemas chinos y evaluar la interoperabilidad y los riesgos de dependencia es vital. Un estándar abierto puede reducir barreras, pero consideren las implicaciones geopolíticas y de PI. Esta estrategia podría forzar una "carrera hacia el abaratamiento" en ciertas capas del stack.

Si China logra establecer un "Android para la IA", ¿qué significará para la innovación global? ¿Un impulso por la accesibilidad o una trampa de dependencia hacia un ecosistema controlado desde Beijing, limitando la soberanía digital de otras naciones?

La transformación del trabajo cualificado: La nueva jerarquía de habilidades

La IA está recalibrando el valor de las habilidades en el desarrollo de software, transformándolo de una artesanía individual a un proceso más industrializado.

La capacidad de "picar código" rutinario, generar boilerplate o realizar depuraciones básicas está siendo progresivamente asumida por herramientas de IA como GitHub Copilot o los asistentes integrados en IDEs.

Esto no significa la extinción de los programadores, sino una redefinición de su valor.

La nueva jerarquía de habilidades devalúa la escritura mecánica de código y eleva aquellas de orden superior. La arquitectura de sistemas –diseñar soluciones complejas, escalables y que integren IA de forma efectiva– se vuelve primordial.

La supervisión crítica y validación del código generado por IA, asegurando calidad, seguridad y alineación con objetivos de negocio, es otra habilidad en alza.

El prompting estratégico y la capacidad de interactuar y guiar a la IA para extraer el máximo valor se convierten en competencias esenciales.

Finalmente, la resolución de problemas abstractos y el pensamiento estratégico para identificar dónde la IA aporta valor real son insustituibles.

McKinsey estima que la IA generativa podría añadir entre $2.6 y $4.4 billones anuales a la economía global, pero solo si la fuerza laboral se adapta.

Están emergiendo nuevos roles: "AI Collaborators", "AI-infused System Architects", "Human-AI Interaction Specialists" y "AI Ethics Officers".

La formación debe virar del simple "aprender a codificar" hacia el pensamiento sistémico, la ética de la IA y la orquestación de la colaboración humano-máquina.

📝 Futurinota: Si la IA se convierte en el "gran igualador" para las tareas de codificación básicas, ¿Qué diferenciará realmente a los equipos de desarrollo? ¿Será la capacidad de formular las preguntas correctas a la IA, más que la de escribir las respuestas?

La crisis de propiedad de los datos: El contrato social roto

La ambigüedad sobre la propiedad y el uso del historial de conversaciones en plataformas como ChatGPT está generando una crisis de confianza y exponiendo a las empresas a riesgos significativos.

Aunque OpenAI asegura que los datos enviados vía API no se usan para reentrenar sus modelos por defecto , las políticas para las versiones de navegador son distintas, y la retención de datos para monitoreo de abuso es una práctica estándar.

El infame caso de Samsung, donde empleados filtraron inadvertidamente código fuente y notas de reuniones confidenciales a ChatGPT, es una cruda advertencia de estos peligros.

Este "contrato social roto de los datos" se manifiesta en una brecha entre las expectativas de los usuarios (individuales y corporativos) y la realidad de cómo su información es tratada. Los riesgos para las empresas son múltiples: fuga de propiedad intelectual, incumplimiento de normativas como GDPR, CCPA o HIPAA (la responsabilidad no se terceriza al usar una API ), y la pérdida de ventaja competitiva si datos estratégicos alimentan modelos que benefician a rivales.

La tensión es inherente:

Los modelos de IA generativa mejoran con más datos, pero este apetito choca con la confidencialidad empresarial

Esto podría impulsar la demanda de soluciones de "IA confiable": modelos auto-hospedados, IA en nube privada (como Azure OpenAI Service ), o técnicas de aprendizaje federado.

📝 Futurinota: ¿Estamos entrando en una era donde el "consentimiento informado" para el uso de datos por IA es una ficción debido a la complejidad sistémica? ¿Quién es realmente el dueño de las ideas o el código "co-creado" con una IA alimentada por datos de millones?

La cura de humildad de la IA: El espejismo de la inteligencia

A pesar del bombo y platillo, recientes estudios están administrando una necesaria "cura de humildad" a las expectativas sobre la IA.

Investigaciones, incluyendo un notable paper de Apple titulado "The Illusion of Thinking" y trabajos publicados en arXiv, revelan que incluso los modelos más avanzados (LRMs como OpenAI o1 o DeepSeek R1) tienden a "rendirse" o fallar estrepitosamente ante problemas que exigen razonamiento complejo, planificación multi-paso o una comprensión intuitiva del mundo físico. Yann LeCun, de Meta AI, ha sido un crítico constante de estas limitaciones, argumentando que los LLMs autorregresivos carecen de componentes clave para una inteligencia genuina.

Estos modelos a menudo exhiben una fluidez lingüística que enmascara una falta de comprensión profunda, llegando a respuestas correctas por heurísticas superficiales o memorización, en lugar de un razonamiento robusto.

La investigación de Apple es particularmente reveladora:

a medida que la complejidad de los problemas lógicos (como la Torre de Hanoi) aumenta, el rendimiento de los LRMs no solo disminuye, sino que colapsa, y los modelos incluso reducen su "esfuerzo" computacional

Este "espejismo de la inteligencia" subraya que la supervisión, el juicio crítico y la intervención humana siguen siendo insustituibles.

La IA es una herramienta prodigiosa, pero no un sustituto del intelecto

Estas limitaciones podrían estar señalando las fronteras del paradigma actual de LLMs para ciertos tipos de razonamiento, lo que podría reorientar la investigación hacia nuevas arquitecturas que integren mejor la lógica formal y el conocimiento del mundo.

📝 Futurinota: Es importante fomentar un escepticismo saludable y una validación rigurosa; una respuesta plausible no es necesariamente correcta. Es preferible diseñar sistemas "human-in-the-loop" donde la IA aumente, pero no decida autónomamente en tareas críticas. Los VC’s deben prestar especial atención al evaluar empresas de IA, indagar sobre sus limitaciones y estrategias de mitigación, no solo sobre sus demos o pueden verse envueltos en fraudes.

Conclusión

La "fiebre del vatio" nos ancla a la realidad: la IA, por digital que parezca, depende de recursos físicos finitos. Simultáneamente, el "espejismo de la inteligencia" nos recuerda que sus capacidades lógicas, aunque asombrosas, también tienen fronteras. Navegar el futuro de la IA exige un delicado equilibrio: ambición para superar estos límites y humildad para reconocerlos, gestionando con igual destreza tanto los recursos del planeta como las expectativas de nuestro intelecto.

¿En que tema o temas te interesa profundizar?